ترانسفورماتورهای از پیش آموزش دیده مولد یا به اختصار (GPT) مانند آنهایی که در چت ربات ChatGPT OpenAI و تولید کننده تصویر Dall-E استفاده میشوند، روند فعلی در تحقیقات هوش مصنوعی هستند. همه میخواهند مدلهای GPT را تقریباً برای همه چیز اعمال کنند و به دلایل مختلف بحثهای قابلتوجهی را برانگیخته است. اما حالا در آخرین نمومه شاهد عرضه یک مدل جدید از هوش مصنوعی با عنوان GPT برای خواندن ذهن انسان هستیم، البته نه به آن شکلی که تصور میکنید.

این ماشین وارد فاز جدیدی از خواندن ذهن انسان شده است

نشریه Scientific American در این رابطه گزارش داده که گروهی از محققان یک مدل GPT ساختهاند که میتواند ذهن انسان را بخواند. این برنامه بیشباهت به ChatGPT نیست زیرا میتواند زبان منسجم و پیوسته را از یک دستور تولید کند. تفاوت اصلی در این است که پارامتر مورد نظر در اینجا تجزیه و تحلیل فعالیت مغز انسان است.

تیمی از دانشگاه تگزاس در آستین به تازگی مطالعه خود را در Nature Neuroscience منتشر کرده است. این روش از تصویربرداری از یک دستگاه fMRI برای تفسیر فعالیت مغزی انسان که به اصطلاح “شنیده، گفتن یا تصور میکند” نامیده میشود استفاده میکند. دانشمندان این تکنیک را کاملا “غیر تهاجمی” میدانند، که طعنه آمیز است زیرا خواندن افکار یک نفر در واقع یعنی نفوذ به بخشی از وجود آن فرد.

البته از نظر علمی و پزشکی، واژهی غیر تهاجمی به این معنی است که روش مورد نظر آنها باعث ایجاد زخم، عمل جراحی یا ایمپلنت یک شی خارجی در بدن فرد مورد نظر نمیشود. البته این تنها موردی نیست که دانشمندان فناوریای را توسعه دادهاند که میتواند افکار را بخواند، اما این تنها روش موفقی است که نیازی به الکترودهای متصل به مغز سوژه ندارد.

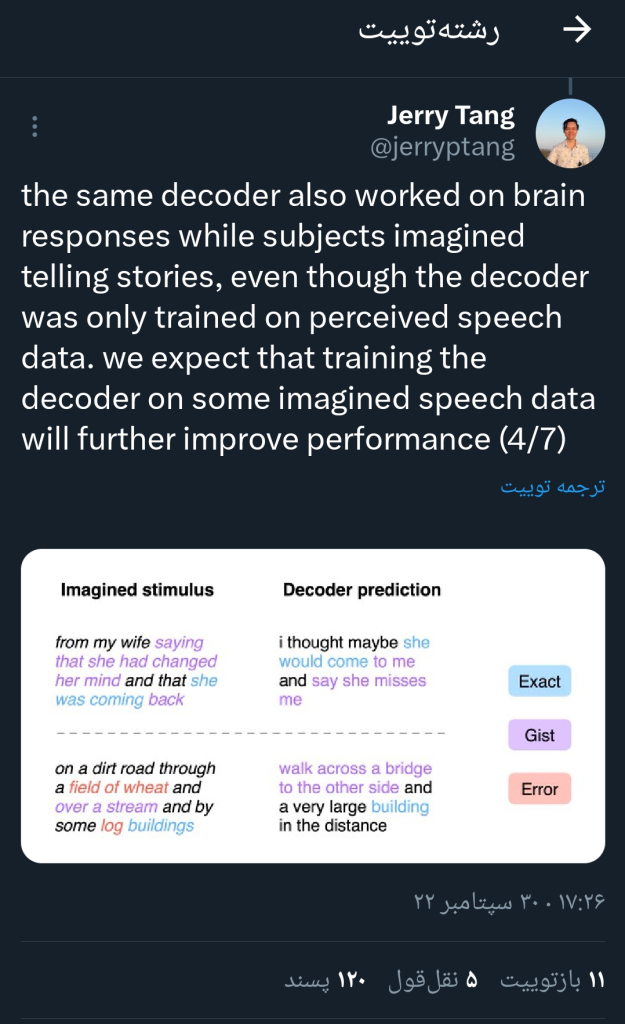

ما رمزگشای خود را روی پاسخهای مغز آموزش دادیم و آزمایش کردیم در حالی که آزمودنیها به داستانهای روایت طبیعی گوش میدادند. با توجه به پاسخهای مغز به داستانهای جدیدی که در آموزش استفاده نمیشد، رمزگشا با موفقیت معنی داستانها را بازیابی کرد.

– Jerry Tang (@jerryptang) September 30, 2022

ذهن مو به مو خوانده نمیشود بلکه ماشین تفکرات انسان را تفسیر میکند

این مدل که GPT-1 نامیده میشود، تنها روشی است که فعالیت مغز را در قالب زبانی پیوسته تفسیر میکند. تکنیکهای دیگر تنها میتوانند یک کلمه یا عبارت کوتاه را بیرون بیاورند، اما GPT-1 میتواند توصیفهای پیچیدهای را ایجاد کند که اصل موضوع را توضیح دهد.

به عنوان مثال، یکی از شرکتکنندگان به صدای ضبط شدهای گوش داد که میگفت: “من هنوز گواهینامه رانندگی خود را ندارم.” مدل زبانی تصویربرداری fMRI را به این معنا تفسیر کرد: “او هنوز شروع به یادگیری رانندگی نکرده است.” بنابراین در حالی که افکار فرد را کلمه به کلمه نمیخواند، میتواند یک ایده کلی از آنچه در ذهن فرد است را پیدا کند و آن را به صورت خلاصه شرح دهد.

البته روشهای تهاجمی میتوانند کلمات دقیق را تفسیر کنند، زیرا آنها برای تشخیص عملکردهای حرکتی فیزیکی خاص در مغز، مانند حرکت لبها برای تشکیل یک کلمه، آموزش دیدهاند. مدل GPT-1 خروجی خود را بر اساس جریان خون در مغز تعیین میکند. درواقع در این روش نمیتوان به طور دقیق افکار را تکرار کرد زیرا در سطح بالاتری از عملکرد عصبی کار میکند.

استادیار الکساندر هوث از مرکز علوم اعصاب و علوم کامپیوتر UT آستین در یک نشست مطبوعاتی پنجشنبه گذشته گفت:

“سیستم ما در سطح بسیار متفاوتی کار می کند. به جای نگاه کردن به این موتور سطح پایین، سیستم ما واقعاً در سطح ایدهها، معناشناسی و معنا کار میکند. این چیزی است که به آن دست پیدا میکند.»

برای رسیدن به این نتیجه از چندین داوطلب کمک گرفته شد. آنها ماشین را بر روی اسکن سه داوطلب که هرکدام ۱۶ ساعت را صرف گوش دادن به داستان های ضبط شده در دستگاه fMRI کردند، آموزش دادند. این فرآیند به GPT-1 اجازه داد تا فعالیت عصبی را به کلمات و ایدههای ضبط شده مرتبط کند.

پس از آموزش، داوطلبان در حین اسکن به داستان های جدید گوش دادند و GPT-1 به طور دقیق ایده کلی آنچه شرکت کنندگان میشنیدند را تعیین کرد. این مطالعه همچنین از فیلمهای صامت و تخیل داوطلبان برای آزمایش این فناوری با نتایج مشابه استفاده کرد.

جالب اینجاست که GPT-1 در تفسیر جلسات ضبط صدا از داستانهای ساختگی شرکتکنندگان دقیقتر عمل میکرد. میتوان آن را به ماهیت انتزاعی افکار تخیلی در مقابل ایدههای ملموستر که از گوش دادن به چیزی شکل میگیرد، تعبیر کرد. با این حال، GPT-1 هنوز در هنگام خواندن افکار ناگفته توانسته بود که بسیار به سوژه مورد نظر نزدیک باشد.

همان رمزگشا همچنین روی پاسخهای مغز کار میکرد در حالی که آزمودنیها داستان گفتن را تصور میکردند، حتی اگر رمزگشا فقط بر روی دادههای گفتاری درک شده آموزش دیده بود. ما انتظار داریم که آموزش رمزگشا بر روی برخی از داده های گفتاری تصوری عملکرد را بیشتر بهبود بخشد.

– Jerry Tang (@jerryptang) September 30, 2022

در یک مورد، فرد داوطلب تصور کرد: “[من] در یک جاده خاکی از میان مزرعه گندم و از روی یک نهر و در کنار چند ساختمان چوبی رفتم.” سپس GPT-1 این اینطور تعبیر کرد: “او باید از روی یک پل به طرف دیگر و یک ساختمان بسیار بزرگ در دوردست میرفت.” بنابراین برخی از جزئیات ضروری و زمینه حیاتی را نادیده گرفت اما همچنان عناصر اصلی تفکر فرد را درک کرد.

باز هم یک فناوری جدید، باز هم دغدغهی حفظ حریم شخصی

ماشینهای هوش مصنوعی که قادر به خواندن ذهن انسان هستند، ممکن است بحثبرانگیزترین نوع فناوری GPT باشد. اما به هرحال تیم در حال فعالیت بر روی این فناوری کمک به بیماران ALS یا آفازی برای صحبت کردن و برقرای ارتباط را هدف والای خود میدانند، اما وجود پتانسیل استفاده نادرست از آن را نیز تصدیق میکنند. هرچند که در حال حاضر برای کار کردن به شکل فعلی نیاز به رضایت سوژه است، اما این مطالعه اذعان میکند که سوءاستفاده کنندگان در صورت دستیابی به این فناوری میتوانند بدون هیچ تعهد اخلاقی از آن استفاده کنند.

در رابطه با همین موضوع در این مقاله آمده است:

«تحلیل حریم خصوصی ما نشان میدهد که در حال حاضر همکاری موضوع {فرد مورد نظر} هم برای آموزش و هم برای اعمال رمزگشا مورد نیاز است. با این حال، پیشرفتهای آتی ممکن است رمزگشاها را قادر به دور زدن این الزامات کند. علاوه بر این، حتی اگر پیشبینیهای رمزگشا بدون رضایت موضوع نادرست باشند، میتوانند عمداً برای اهداف مخرب سوء تعبیر شوند. به این دلایل و سایر دلایل پیشبینی نشده، افزایش آگاهی از خطرات بسیار مهم است. از فناوری رمزگشایی مغز و اتخاذ سیاستهایی که از حریم خصوصی ذهنی هر فرد محافظت میکند.”

البته، در این سناریو فرض میشود که فناوری fMRI میتواند به اندازه کافی کوچک شود تا در خارج از یک محیط بالینی کاربردی باشد. که البته فعلا برای رسیدن به چنین جایگاهی باید سالها کار کرد. اما به هرحال این فناوری نیز میتواند مانند یک تیغ دولبه باشد، از کمک به معلولین برای مکالمه تا سوءاستفاده برای تخلیه اطلاعاتی افراد بدون رضایت آنها.

مطالب مرتبط:

دیدگاهتان را بنویسید